Mitä vaihtoehtoja lisensseille on?

Power BI -lisensointiin on lukuisia eri vaihtoehtoja. Microsoftin sivuilla jaotellaan eri lisenssimallit kolmeen kategoriaan (Pricing & Product Comparison | Microsoft Power BI):

- Power BI ilmaisversio osana Fabric:ia

- Power BI Pro

- Power BI premium

Tämän jaottelun lisäksi Power BI premium jakautuu vielä kolmeen erilaiseen vaihtoehtoon:

- Power BI Premium Per User

- Power BI Premium

- Power BI embedded

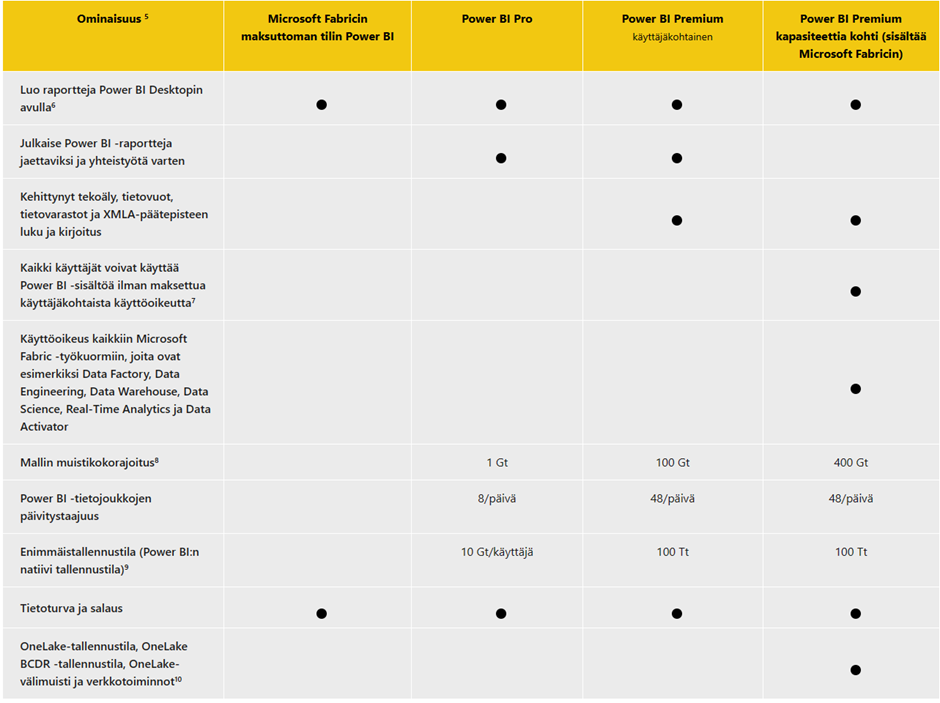

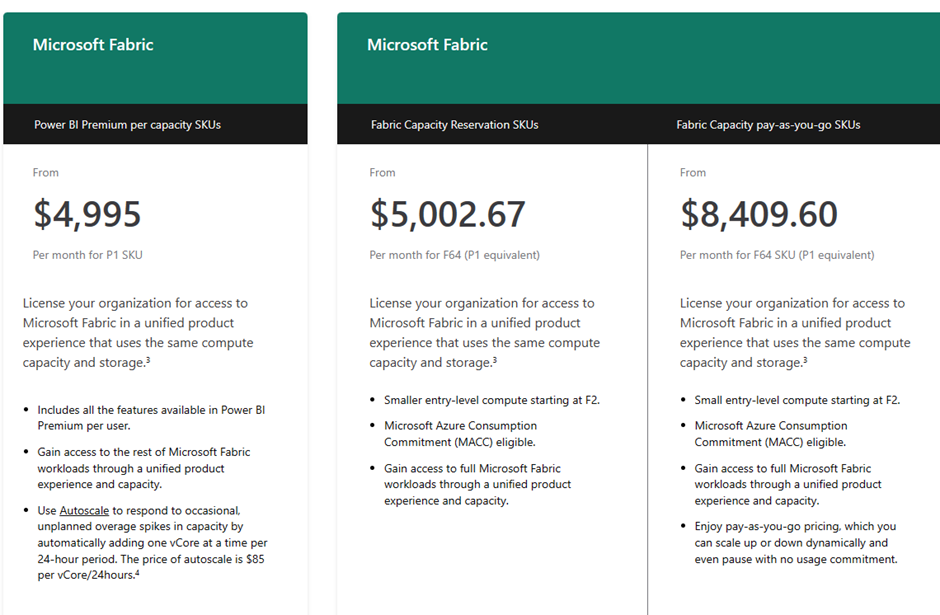

Näistä vaihtoehdoista Power BI Premium ja Power BI embedded perustuvat premium kapasiteetin hankintaam, johon vaihtoehtoina on mm. Power BI premium per capacity SKUs, Fabric Capacity Reservation SKUs ja Fabric Pay-as-you-go SKUs. Yhteensä mallit voidaan jaotella neljään kategoriaan seuraavan kuvan mukaisesti:

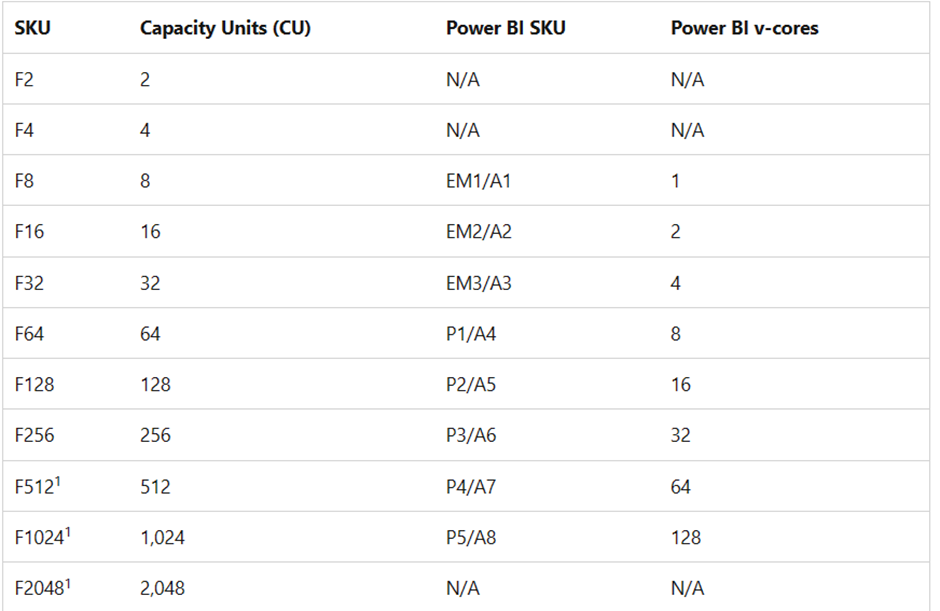

Näistä vaihtoehdoista “Premium per capacity” jakautuu F-, P- ja A-kapasiteetteihin, joilla on eri hinnoittelumallit. Kapasiteettien eroja voi tarkastella seuraavasta dokumentista: What is Power BI Premium? – Power BI | Microsoft Learn

Power BI Pro:ta voidaan kutsua Power BI:n “perusversioksi”. Sen hinnoittelu on lähtökohtaisesti 10$ kuukaudessa per käyttäjä. Jotta Power BI:tä voi käyttää Power BI servicessä, käyttäjillä tulee olla Power BI Pro -lisenssi. Power BI:n ilmaisversiolla voi rakentaa raportteja, mutta niitä ei voi jakaa muille käyttäjille Power BI Servicen kautta.

Mitä Power BI Pro sisältää?

Power BI Pro on lähtökohtaisesti ensimmäinen lisenssi, jolla BI:n hyötyihin pääsee käsiksi. Se mahdollistaa suuremman datamallin, ajastetut datan päivitykset sekä Power BI -raporttien jakamisen toisille käyttäjille, joilla on Power BI Pro / Premium -lisenssi. Voimme tarkastella eroja paremmin oheisen Microsoftin taulukon perusteella:

Taulukko 1: Power BI lisenssit

Käytännön tasolla Power BI Pro on kevein tapa jalkauttaa moderni itsepalveluraportointi organisaatioon. Power BI Pro -lisenssi on lähtökohtaisesti suunniteltu raporttien kehittäjille ja se mahdollistaa kaikki muut raporttien jakelumetodit, paitsi Power BI embeddedin.

Power BI Premium

Power BI premium puolestaan antaa lisätyökaluja Power BI:n ammattimaiseen kehittämiseen. XMLA-päätepisteet ovat erittäin tehokas tapa muokata Power BI servicessä olevia raportteja ilman, että raportteja täytyy ladata työpöydälle. XMLA:n kautta pystyy tekemään mallin muokkaamisen lisäksi muita toimintoja, kuten päivittämään Power BI:n semanttisen mallin datat. Tämän lisäksi premium tarjoaa laajemmat data mallit, tiheämmän päivityssyklin sekä osan Azuren AI-toiminnallisuuksista. Premiumin kaksi eri vaihtoehtoa, PPU- ja kapasiteettipohjainen Premium sopivat eri kokoisille organisaatioille. PPU sopii organisaatioille, jotka eivät ole vielä niin isoja, että tuhansien eurojen hintainen kapasiteetti olisi ajankohtainen hankinta, mutta jotka silti haluavat käyttää Premiumin käteviä toiminnallisuuksia.

Kapasiteettipohjaiset lisenssit

Power BI Premium, Power BI embedded, Fabric-kapasiteetti ja Fabric pay-as-you-go kattavat kaikki Power BI:n ominaisuudet. Näissä malleissa tilaus varaa vaihtelevan määrän kapasiteettia käyttöön oheisen taulukon mukaisesti:

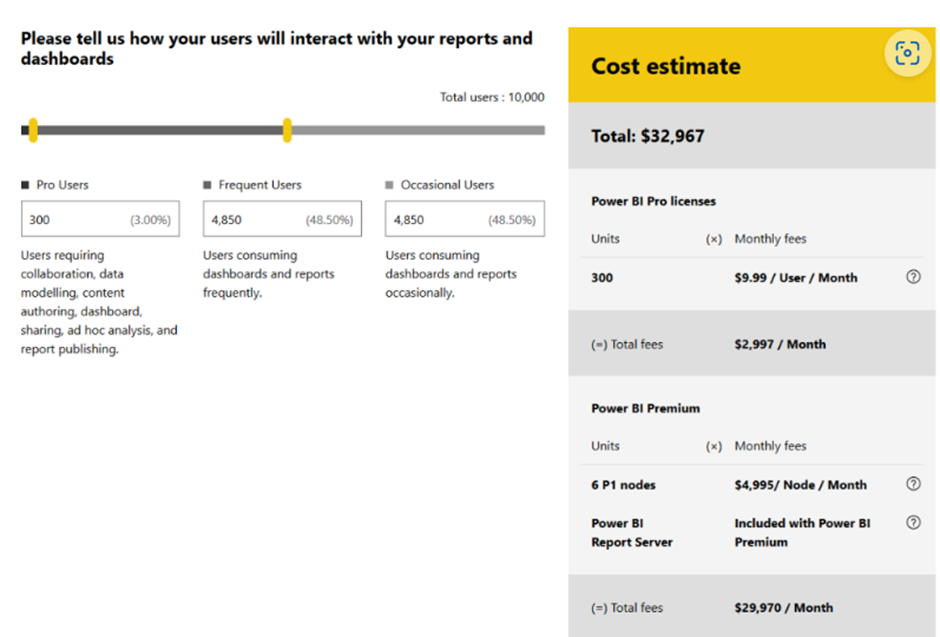

Kapasiteettipohjaiset mallit ovat nopeasti kustannustehokkaita isoissa organisaatioissa. Esimerkkinä tästä seuraava laskelma:

Käyttämällä Premium-kapasiteettia kokonaiskustannus 10 000 käyttäjälle on 29,970 $. Vastaavasti pelkillä lisensseillä tämä kustannus olisi noin 100 000 $. Kapasiteettipohjaisissa malleissa on myös muita pieniä eroja toiminnallisuuksien välillä. Power BI embedded mahdollistaa Power BI:n upottamisen esimerkiksi nettisivulle tai intranettiin. Fabric kapasiteetti puolestaan antaa pääsyn Fabricin toiminnallisuuksiin. Power BI:n kontekstista näistä merkittävin on pääsy co-pilot -toiminnallisuuksiin. Minimivaatimus tähän on kuitenkin F64-kapasiteetti. Lisätietoja Fabric-kapasiteetin hinnoittelusta on saatavilla täältä: Microsoft Fabric – Pricing | Microsoft Azure.

Fabric-kapasiteetti on erityisen tärkeä, sillä kuten tässä Microsoftin blogissa mainitaan: Important update coming to Power BI Premium licensing | Microsoft Power BI Blog | Microsoft Power BI

Fabric-kapasiteetti korvaa Power BI premium per capacityn kokonaisuudessaan. Heinäkuun ensimmäisestä päivästä alkaen Power BI premium kapasiteettia ei voi enää ostaa vaan sen sijasta Fabricin F-kapasiteetit korvaavat premiumin SKU-kapasiteetit. 2025 tammikuussa olemassa olevat kapasiteetit tulisi muuttaa F-kapasiteettiin.

Käytännön tasolla Fabric-kapasiteetit jakautuvat kapasiteetin varaukseen ja pay-as-you go malliin:

Kapasiteetin varaus on hieman kalliimpi kuin vastaava premium per capacity P-kapasiteetit. Lisätietoja näiden kahden hinnoittelumallin eroista löytyy täältä:

Pricing & Product Comparison | Microsoft Power BI

Tuleva muutos, jossa Power BI premium kapasiteetit korvataan Fabric kapasiteeteilla, ei vaikuta Power BI pro- tai Power BI premium per user -lisenssimalleihin.

Microsoft Power BI on markkinaa johtava Business Intelligence (BI)-työkalu, joka tarjoaa organisaatioille mahdollisuuden jalostaa raakadataa toimintakelpoisiksi raporteiksi. BI-työkalujen käyttöönotossa keskitytään usein painotetusti alustan teknisiin mahdollisuuksiin, jolloin raporttien ulkoasun muotoilu ja käyttöliittymän merkitykset saattavat jäädä varjoon. Tasapainon löytäminen teknologian ja muotoilun välillä on kriittistä rakennettaessa Power BI-raportteja, jotka ovat sekä toiminnallisesti vankkoja että visuaalisesti houkuttelevia ja intuitiivisia. Pohditaanpa tarkemmin, miksi tämä tasapaino on tärkeä ja miten se voidaan tehokkaasti saavuttaa.

Power BI:n taustateknologiat

Power BI on ytimeltään monipuolinen alusta, joka tarjoaa edistyneitä ominaisuuksia datan käsittelyyn, muokkaamiseen ja visualisointiin, mukaan lukien Power Query -työkalu datan yhdistämiseen ja muokkaamiseen eri lähteistä. Aina datan mallinnuksesta ja DAX-laskelmista interaktiivisiin koontinäyttöihin ja tekoälyohjattuihin oivalluksiin asti, Power BI tarjoaa laajan valikoiman työkaluja, joiden avulla datan potentiaalia voidaan hyödyntää. Kuitenkin teknisten ominaisuuksien moninaisuus saattaa joskus hämärtää muotoilun roolia.

Power BI:n laskenta näkyy loppukäyttäjille usein universaalisti tunnistettavissa visualisoinneissa, kuten taulukoissa, viiva- ja pylväsdiagrammeissa. Tämä taulukkolaskennasta tuttu tapa esittää dataa on usein harhaanjohtava, sillä toisin kuin esimerkiksi Excelissä Power BI:n taustalla oleva laskenta ei tapahdu taulukkokontekstissa vaan perustuen seuraaviin teknologioihin: DAX, formula engine (FE) ja storage engine (SE). Kun loppukäyttäjä käyttää Power BI-raporttia, seuraavat prosessit käynnistyvät:

- Raporttiin määritellyt DAX-laskelmat käynnistyvät

- FE tulkitsee nämä laskelmat ja kyselee SE:tä

- Riippuen yhteystyypistä import/direct query/composite model VertiPaq tai SQL hakee tarvittavan datan, tekee vaaditut transformaatiot ja palauttaa tulokset FE:lle

- FE esittää lasketun datan käyttäjälle visualisaatioiden kautta

Muotoilun merkitys Power BI-raportoinnissa

Muotoilu toimii sillanrakentajana, joka yhdistää käyttäjät dataan. Se ei ole pelkästään raporttien ulkoasun kaunistamista, vaan sen tarkoituksena on parantaa käytettävyyttä, helpottaa ymmärrystä ja lisätä sitoutumista. Tehokas muotoilu varmistaa, että käyttäjät voivat vaivattomasti navigoida läpi monimutkaisten tietojoukkojen, tulkitsevat dataa selkeästi ja tekevät toimintakelpoisia päätelmiä. Väreillä, visualisointien sijainnilla, negatiivisella tilalla ja visualisointien määrällä on kaikilla vaikutusta siihen, miten Power BI-raportteja tulkitaan.

Kuten eräs yleinen lausahdus menee, “form is part of function” tai karkeasti käännettynä, muoto on osa toiminnallisuuutta. Tämä lausahdus pätee erityisesti Power BI:n kontekstissa, sillä hyvin muotoiltu raportti on usein myös performanssiltaan parempi, kuin nopeasti kasaan kyhätty viritelmä. Koska Power BI:n teknologiat lähettävät kyselyitä tallennusmoottorin kautta, monimutkainen raportti on performanssiltaan erittäin huono. Tämä ei suinkaan ole ainoa ongelma, sillä ihmisen lyhytkestoinen muisti pystyy käsittelemään keskimääräisesti viidestä yhdeksään erilaista informaation palasta. Tästä syystä raportit, joissa on kymmeniä mittareita ovat tehottomia, sillä niitä on vaikea käsitellä kokonaisuutena.

Asian visualisomiseksi verrataan kahta eri raporttipohjaa:

Kuva 1: Toimiva Raporttipohja

Kuva 2: Liian Monimutkainen Raportti

Kuva 1 on yleinen raporttipohja, mikä noudattaa yleistä silmän liikerataa ja sisältää hallittavan määrän elementtejä. Vaaleansiniset kentät symboloivat erilaisia visualisointeja. Kuva 2 on myös valitettavan yleinen layout, mikä sisältää lukuisia KPI-laatikoita. Tällainen raporttipohja kerää näennäisesti paljon dataa pieneen tilaan, mutta tilastollisesti se on liian monimutkainen ihmisen lyhytkestoiselle muistille. Tällainen raportti on liian ”kiireinen” ja siinä on liian paljon negatiivista tilaa. On epätodennäköistä, että raportin käyttäjä pystyy sisäistämään kaikkia mittareita, mitä raportilla esitetään ja tästä syytä en suosittele tällaista rakennetta.

F, Z ja 19 sekuntia

Web-muotoilu antaa paljon hyviä eväitä raporttien muotoiluun, sillä monet lainalaisuudet mitkä pätevät nettisivujen rakentamisessa ovat totta myös raportointikontekstissa. Kaksi yleisintä tapaa miten ihmiset tulkitsevat raportteja ja nettisivuja ovat F- tai Z-kuviot. Jos raportissa ei ole näiden kuvioiden ”rikkovia” elementtejä, ihmisen silmät aloittavat sisällön tulkitsemisen pohjan vasemmasta yläreunasta. Tästä syystä tämä sijainti on ensisijaisen tärkeä ja tärkein data tulisi aina sijoittaa sinne. Kuvat 3 ja 4 ovat esimerkkejä näistä kuvioista. Numerot esittävät silmien liikejärjestystä näissä skannaustavoissa.

Kuva 3: Z-kuvio

Kuva 4: F-kuvio

Raportteja suunniteltaessa tämä silmien liikerata antaa hyvän lähtökohdan sille, mihin informaatio tulisi sijoittaa. Raportin yläreuna on erityisen tärkeä ja oikeaan alareunaan voi piilottaa salaisuuksia. Skannausprosessi kestää keskimäärin 19 sekuntia mikä on hyvin lähellä lyhytkestoisen muistin keskimääräistä pituutta (22,5). Tämä silmien liikerata selittää myös sitä miksi useimmat hakutulokset ”Power BI Dashboard Examples” noudattavat kyseistä asettelua. Kuva 5 on esimerkki tästä ja useimmissa esimerkeissä nousee esille vasemman yläreunan merkitys.

Kuva 5: Power BI Dashboard Examples

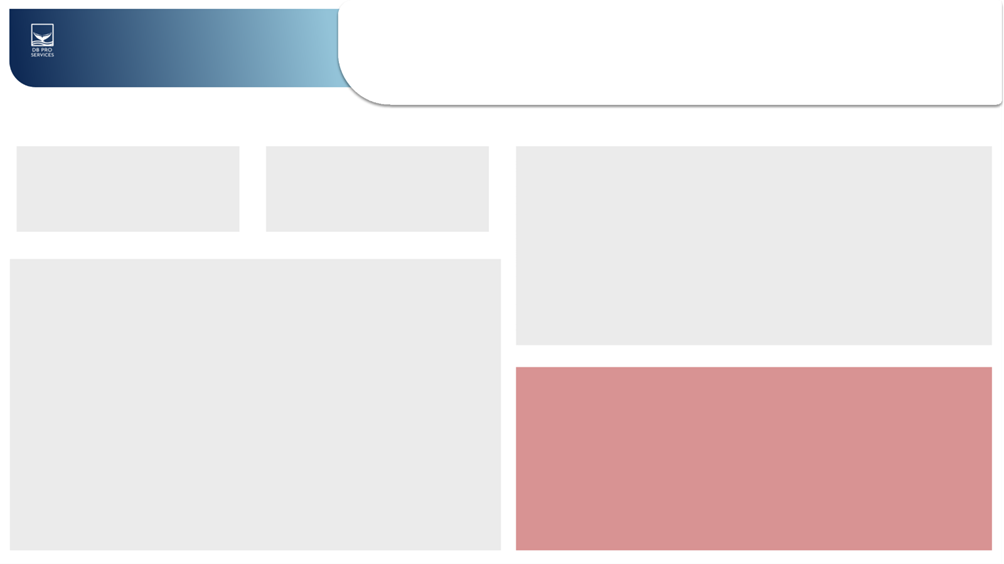

Mainitsemani 19 sekuntia antaa hyvän viitekehyksen sille, miksi raportteja rakennettaessa yksinkertainen on kaunista. Jos loppukäyttäjä ei löydä tarvitsemaansa tietoa nopeasti Power BI-raportilta, on hyvä kohta miettiä, onko raporttisi liian monimutkainen. F- ja Z-kuviot eivät kuitenkaan ole absoluuttisia totuuksia ja tietyt muotoiluelementit muuttavat loppukäyttäjän tyypillistä käytöstä. Power BI-raportoinnin näkökulmasta kaksi merkittävintä tällaista elementtiä ovat kontrasti ja isot numerot. Kuvat 6 ja 7 ovat esimerkkejä näistä tilanteista.

Kuva 6: Iso numero

Kuva 7: Kontrasti

Iso numero ei tässä kontekstissa tarkoita, että numero olisi suuri vaan sitä, että käytetty visualisointi sisältää fontiltaan suuren numeron. Käytettäessä tällaista elementtiä on todennäköistä, että silmä ajautuu kohti tätä numeroa. Suuri värikontrasti aiheuttaa saman ilmiön ja punainen alue kuvassa 7 todennäköisesti herätti huomiosi.

Värien merkitys raportoinnissa

Kontrastin lisäksi väreillä on muitakin merkittäviä ominaisuuksia, jotka vaikuttavat raportin analysointiin. Väreillä voi esimerkiksi signaloida, minkä kaltaista analysoitava data on. Monokromaattinen väripaletti voi signaloida, että data mitä analysoidaan on luonteeltaan samankaltaista, eikä sisällä dimensiotietoja. Lähivärit puolestaan voivat signaloida, että analysoitavat asiat liittyvät läheisesti toisiinsa, mutta eroavat silti keskenään. Esimerkkinä tästä tutkitaan kuvia 8 ja 9.

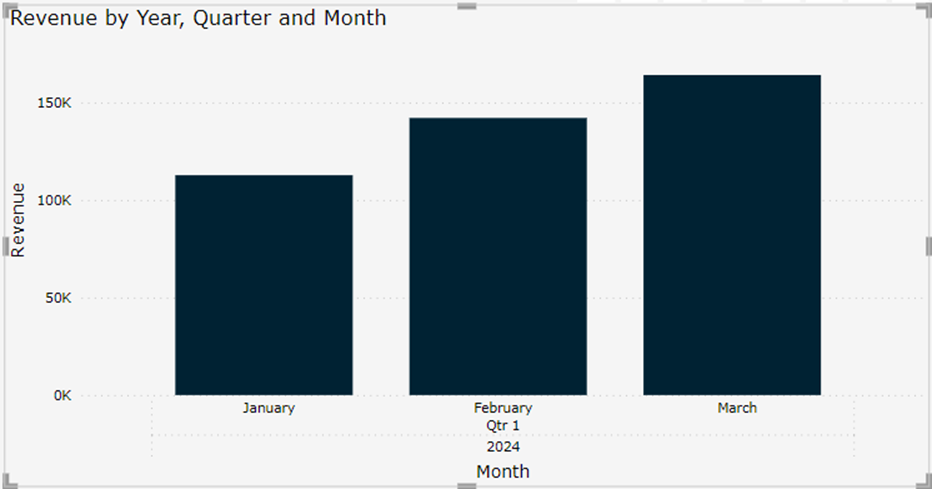

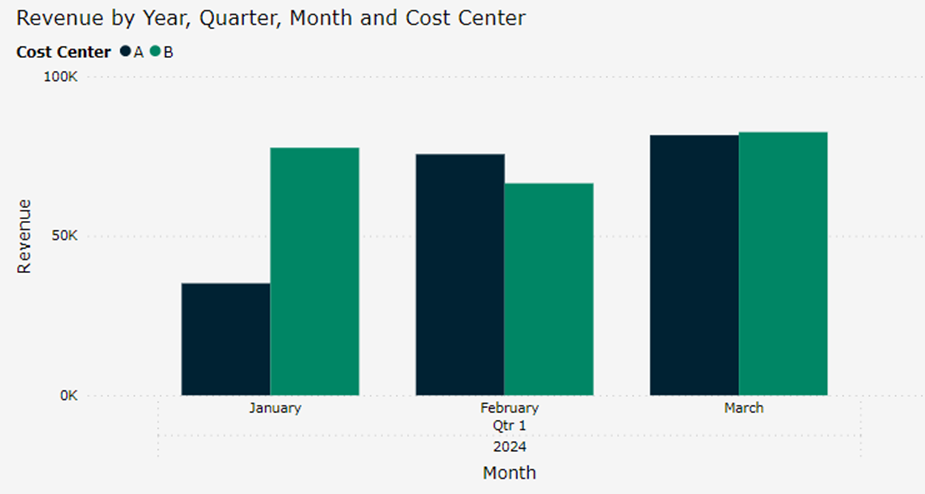

Kuva 8: Liikevaihto Q1

Kuva 9: Liikevaihto Q1 kustannuspaikoittain

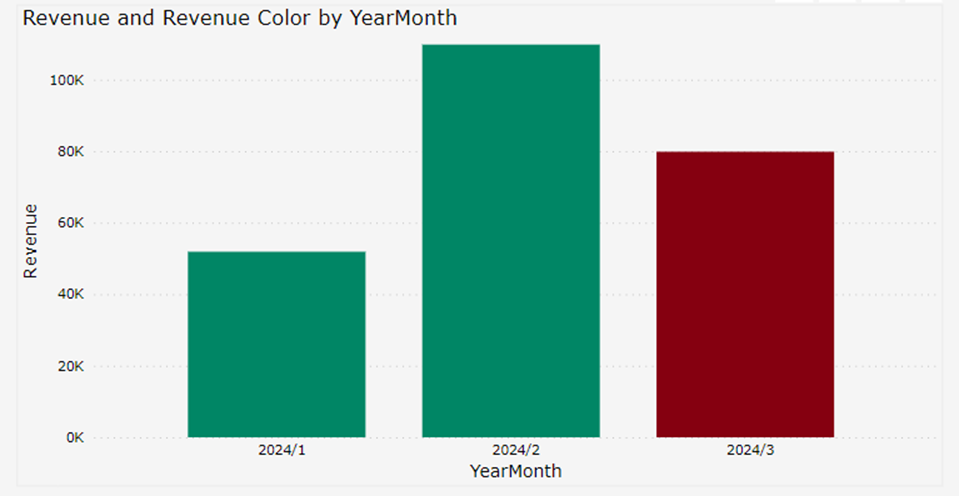

Molemmat kuvat esittävät pylväsdiagrammeja, joissa liikevaihto esitetään kuukausittain. Kuvassa 9 liikevaihto on kuitenkin jaoteltu kustannuspaikoittan lähivärit sininen ja vihreä signaloivat tässä kontekstissa sitä, että molemmissa tapauksissa analysoitava data on samankaltaista, mutta kuitenkin eroaa toisistaan. Kuvassa 10 liikevaihtoa halutaan analysoida muutoksen näkökulmasta. Tästä syystä vastavärit vihreä ja punainen luovat maksimaalisen kontrastin ja esittävät positiivista sekä negatiivista muutosta.

Kuva 10: Liikevaihdon muutos viime kuukauteen verrattuna

Suunniteltaessa Power BI-raporttia ja rakentaessa tarinaa, minkä haluat datallasi kertoa, tämänkaltaiset tavat hyödyntää värejä voivat auttaa loppukäyttäjiä sisäistämään raportin datan nopeammin. Toisaalta väreillä voidaan myös johtaa harhaan ja luoda vääränlaisia mielikuvia datasta. Tästä syystä värien merkitys on aina hyvä pitää mielessä raportteja rakennettaessa.

Akselien merkitys

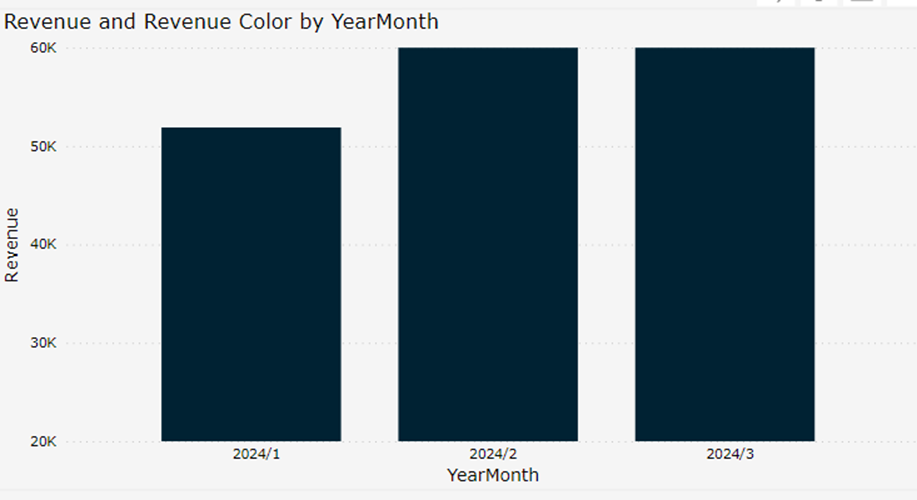

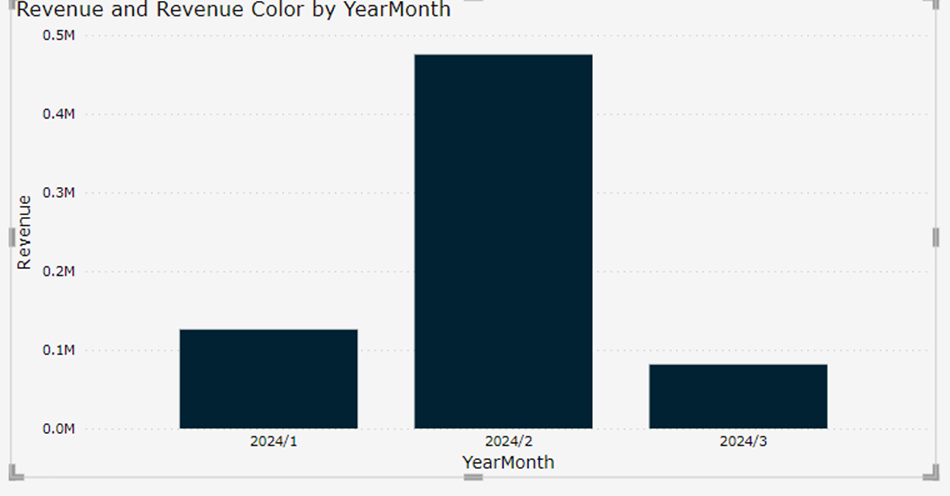

Kuten autoissa, akselit ovat kriittinen osa datan visualisointia. X- ja Y-akseleilla voidaan vaikuttaa siihen, missä kontekstissa dataa tulkitaan. Kuva 11 sisältää saman datan kuin kuva 10, mutta sitä on rajattu muuttamalla Y-akselien skaalaa.

Kuva 11: Rajattu Y-akseli

Kuva 11 on äärimmäinen esimerkki, ja tämän kaltaista tahallista datan väärinesittämistä ei esiinny usein. Toisaalta jos akselien merkitykseen ei kiinnitä riittävää huomioita raporttia rakentaessa, Power BI:n oletusasetus akselien autoskaalauksesta voi aiheuttaa samankaltaisen ilmiön huomaamatta. Kuvassa 12 käytetty data on muuten sama kuin kuvissa 10 ja 11, mutta helmikuun liikevaihto on kolminkertainen. Autoskaalaus muuttaa tässä tapauksessa Y-akselin miljooniin.

Kuva 12: Akselin autoskaalaus voi muuttaa kontekstia

Jos raportin käyttäjät ovat käyttäneet raporttia pidemmän aikaa ja tämä ilmiö tapahtui datan automaattisen päivityksen yhteydessä, on mahdollista, että muutos jää huomaamatta. Vaikutus ei tässä esimerkissä ole suuri, mutta se muuttaa datan tulkinnan kontekstia. Jos uusi käyttäjä tutustuu raporttiin tässä kohtaa, hän tulkitsee dataa eri kontekstista kuin aikaisemmat käyttäjät.

Yhteenveto

Käsittelin tässä blogissa erilaisia tapoja, miten raporttien muotoilu vaikuttaa datan tulkintaan ja miksi se on erityisen tärkeää Power BI-raportteja rakentaessa. Monimutkaiset ja huonosti muotoillut raportit ovat raskaita tallennusmoottorille ja ne voivat johtaa vääränlaiseen datan tulkintaan. Visualisointien sijainnilla ja esitystavalla on merkitystä siihen kuinka todennäköisesti loppukäyttäjä tarkastelee kuvaajaa ja minkälaisia mielikuvia data herättää. Väreillä voidaan luoda mielikuvia datasta ja niillä voidaan ohjata käyttäjän katsetta. Akselit voivat vaikuttaa siihen. missä kontektissa data tulkitaan ja niillä voidaan rajata data erilaisten käsitysten luomiseksi. Jos haluat välttää näitä muotoilun sudenkuoppia ja kuulla lisää asiasta, älä epäröi olla yhteydessä.

Lähteitä ja lisälukemista aiheesta:

Design effective reports in Power BI – Training | Microsoft Learn

Dashboard Design: A study on eye tracking (tableau.com)

https://create.microsoft.com/en-us/learn/articles/what-is-color-theory

Formula engine and storage engine in DAX – SQLBI

Lue myös:

Mitä on Power BI vuonna 2024,

Miksi ulkoistaa data-analytiikan kehitys?

Power BI pro ja eri lisensointimallit

Fabric on luonut paljon mielenkiintoa Power BI:tä kohtaan ja vaikka työkalu sopii erinomaisesti self-service ja in-house -kehittämiseen ennen projektien aloittamista on hyvä miettiä, kannattaisiko kehitystä ulkoistaa. On selvää, mihin lopputulemaan tämä kirjotus päätyy, sillä työskentelen itse datakonsultoinnin parissa, mutta siitä huolimatta pyrin esittämään argumentteja ulkoistamisen puolesta.

Power BI-konsultointi voi keskittyä moneen eri asiakokonaisuuteen, mutta esimerkiksi viidellä otsikolla jaoteltuna mahdollisia ulkoistamisen etuja ovat:

1. Kokemus ja asiantuntemus

2. Kustannustehokkuus

3. Skaalautuvuus ja joustavuus

4. Uusimmat teknologiat ja parhaat käytännöt

5. Tehostettu resurssienhallinta

Käsittelen tässä blogissa nämä aihekokonaisuudet ja esitän argumentteja siihen miksi Power BI -konsultti on oikea ratkaisu data-analytiikan ulkoistamiseen. Nämä viisi kokonaisuutta eivät todellakaan ole ainoat otsikot siitä, miten ulkoistamista voi lähestyä, mutta ne ajavat hyvin asiansa Power BI-ulkoistamisen kontekstissa.

Kokemus ja asiantuntemus

Power BI:hin erikoistuneet konsultit ovat nähneet lukuisia erilaisia ympäristöjä ja projekteja, joten heillä on laaja-alainen näkemys erilaisista tosielämän ratkaisuista sekä niihin liittyvistä haasteista. Yksi yleisimpiä kysymyksiä, minkä asiakkaat minulle usein esittävät on että: “Miten tämä on ratkottu muualla?”. Konsulteilla on myös usein aiemmista projekteista muodostuneita koodikirjastoja ja raporttilayoutteja, mitä he voivat soveltaa nopeuttaen raporttien ja analytiikan kehitystä.

Yksi merkittävä ero in-house -kehittäjän ja konsultin välillä on erikoistuminen. Power BI julkaistiin erillisenä ohjelmistona vuonna 2015. Olen itse käyttänyt Power BI:tä vuodesta 2016 alkaen ja rakentanut vuosien aikana niin monta raporttia, että en enää pysy laskuissa mukana. In-house -kehittäjillä on usein muita ydinliiketoimintaan liittyviä vastuita ja tästä syystä heidän työnsä harvemmin painottuu yhtä vahvasti analytiikkaan.

Self-service -analytiikka viittaa analytiikkaan, missä liiketoimintakäyttäjät rakentavat itse raportointinsa ilman IT- tai data-ammattilaisten tukea. Excel-raportointi on siis määritelmän mukaan self-service -analytiikkaa. Tällaisella raportoinnilla on paikkansa ja taulukkolaskentaraportit tulevat tuskin koskaan häviämään, mutta rakennettaessa koko organisaation kattavia raportteja, joilla voi olla kymmeniä, satoja tai jopa tuhansia käyttäjiä, tällainen raportointi on harvemmin oikea ratkaisu. Itselle rakennettu raportti ja yleiseen jakeluun tarkoitettu raportti ovat fundamentaalisesti erilaisia olentoja ja rakentaessa analytiikkaa, jolla on useita käyttäjiä, on hyvä tiedostaa tyypillisimmät käyttäjävirheet ja UI- / UX -muotoilun periaatteet. Power BI -konsulteilla on tämä kokemus ja ulkoistamalla raportoinnin kehityksen liiketoiminta voi hyödyntää tätä osaamista.

Kustannustehokkuus

Power BI konsulttien tuntihinnat voivat tuntua joskus korkeilta, mutta toisaalta verrattuna in-house -kehittäjän palkkaamiseen kehityksen ulkoistaminen konsultille on usein kustannustehokkain vaihtoehto rakentaa dashboardeja ja raportteja. In-house -data-analytiikkaan liittyy aina yleiskustannuksia, jotka voidaan kokonaan välttää ulkoistamalla. Yleiskustannusten minimointi onkin asia, mitä kannattaa erityisesti tarkastella, kun raportoinnin kehittämistä tehdään projektiluontoisesti. Muutama klassinen esimerkki tämän tyylisistä raportoinneista ovat mm:

- Talousraportoinnin kehittäminen ennen budjetointia,

- analytiikan migraatio järjestelmästä toiseen tai jopa:

Excelissä tehdyn raportoinnin siirtäminen Power BI:hin.

Skaalautuvuus ja joustavuus

Projektiluontoinen Power BI -kehitys kannattaa ulkoistaa myös analytiikan skaalautuvuuden ja joustavuuden näkökulmasta. Kaikki projektit eivät ole verrannollisia ja liiketoiminnallasi saattaa olla tarve rakentaa laaja-alainen raportointikokonaisuus hyvinkin nopealla aikataululla. Tällaisessa tapauksessa puitesopimus konsulttitalon kanssa on kullanarvoinen työkalu. Uusien työntekijöiden palkkaaminen on pitkäkestoinen prosessi ja viimeaikaiset trendit ovat pitkittäneet tätä prosessia entisestään.

Ulkoistamalla Power BI -kehityksen konsultille voit saada parhaimmillaan uuden osaajan projektiisi jo seuraavana päivänä. Minulla on tästä henkilökohtaista kokemusta ja muistan erään kerran, kun kollegani kysyi neljän aikaan iltapäivästä, pääsisinkö huomenna auttamaan asiakkaan projektissa, sillä asiakkaalla oli aikataulupaine raportoinnin suhteen. Otin nopean puhelun asiakkaan edustajan kanssa, allekirjoitin tarvittavat paperit ja seuraavana aamuna suuntasin kahdeksan aikaan asiakkaan toimistolle. Kun projekti oli saatu onnistuneesti maaliin, toimeksiantoni loppui kyseisellä asiakkaalla ja näin asiakas sai käytettyä analytiikkabudjettinsa tehokkaasti.

Joustavuus toimii siis myös, kun et ole varma, paljonko resursseja tarvitset pitkällä aikavälillä. Ulkoistamalla data-analytiikkaa pystyt siis mitigoimaan liiketoimintasi riskejä. Kun haluat rajoittaa analytiikkaasi, allokoituja resursointia pystyy joustavasti skaalaamaan alaspäin sopimusten puitteissa.

Uusimmat teknologiat ja parhaat käytännöt

Power BI:hin erikoistunut konsultti on ajantasalla Power BI:n uusista toiminnallisuuksista ja parhaista käytännöistä, sillä konsulttitalon liiketoiminta perustuu hänen ammattitaitoonsa. Luen henkilökohtaisesti Power BI:n virallista blogia, foorumeita ja muita Power BI:hin liittyviä kanavia päivittäin, ja tällä tavoin olen aina aallonharjalla siitä mihin työkalu kykenee. Tämän lisäksi sparrailen säännöllisesti kollegoideni ja kontaktieni kanssa aiheen tiimoilta. In-house -kehittäjillä ei aina ole samoja mahdollisuuksia ja usein heillä on muita yrityksen pääliiketoimintaan liittyviä vastuita.

Ulkoistamalla Power BI -kehityksen voit olla luottavainen, että saat alan uusimmat ja parhaaksi todetut käytännöt osaksi projektejasi.

Power BI ja Fabric voivat hallinnollisesti olla monimutkaisia kokonaisuuksia. Ulkoistamalla toiminnon saat myös laaja-alaisemman käsityksen siitä, mitä lisenssivaatimuksia erilaiset toiminnot vaativat. Konsulttien aikaisempi kokemus erilaisista ympäristöistä antaa paremman näkemyksen esimerkiksi siitä, milloin Power BI:ssä kannattaa käyttää Premium Per Useria, mitä eroja on A-, P- ja F-kapasiteetilla sekä milloin Power BI pro on oikea ratkaisu lisenssien hallinnointiin.

Tehostettu resurssienhallinta

Olen jo useaan otteeseen maininnut, että in-house -kehittäjällä on usein ydinliiketoimintaan liittyviä vastuualueita. Yksi ulkoistamisen eduista onkin se, että kehitykseen sidotut resurssit voivat keskittyä ydinliiketoiminnan prosesseihin ja kehittämiseen. Sen sijaan, että organisaatio käyttäisi aikaa ja rahaa Power BI:n parhaiden käytäntöjen ja uusimpien trendien opiskeluun, ulkoistamalla Power BI -kehityksen yritys voi keskittyä sen avainosaamiseen ja näin tuottaa lisäarvoa tehokkaammin. Monet Suomen suurimmista yrityksistä ovat ulkoistaneet datatoimintojansa – olisiko sinunkin organisaatiossasi aika toimia näin?

Yhteenveto

Käsittelin tässä kirjoituksessa syitä siihen, miksi Power BI kehityksen ulkoistaminen konsultin avulla on usein hyvä idea. Viisi pointtia ulkoistamisen puolesta olivat:

1. Kokemus ja asiantuntemus

2. Kustannustehokkuus

3. Skaalautuvuus ja joustavuus

4. Uusimmat teknologiat ja parhaat käytännöt

5. Tehostettu resurssienhallinta

Toivottavasi kirjoitukseni herätti ajatuksia. Mikäli etsit tämän perusteella analytiikkakumppania, lisään loppuun vielä lyhyen kirjoituksen siitä, miksi DB Pro Services Oy on paras vaihtoehto.

Miksi DB Pro Services Oy on erinomainen valinta kumppaniksi?

DB Pro Services Oy:n konsultit ovat syväosaavia, sertifioituja Microsoft Business Intelligence- ja Data Platform -ammattilaisia sekä on-premise että Azure-pilviratkaisuissa. Jos blogini herätti ajatuksia siitä, että raportoinnin ulkoistaminen konsulteille voisi olla hyvä idea, ole ihmeessä yhteydessä. Löydät yhteydenottolomakkeen nettisivumme alareunasta.

Jos haluat pysyä tiedolla johtamisen aallonharjalla ja lukea lisää blogeja dataan liittyen, voit liittyä sähköpostilistallemme oheisesta linkistä: https://dbproservices.fi/liity-tiedolla-johtamisen-eturintamaan/

Tämä blogi kertoo siitä, miksi juuri sinun tulisi käyttää Power BI:tä vuonna 2024 liiketoiminnassasi ja mitkä ovat työkalun tärkeimmät ominaisuudet. Kirjoituksen luettuasi osaat vastata siihen, mikä Power BI on, miksi se on parempi ratkaisu analytiikkaan kuin Excel, sekä mitä kustannuksia työkalun käyttöönotosta tulee.

Mikä Power BI on?

Lyhyesti sanottuna Power BI on Microsoftin kehittämä tehokas liiketoimintatiedon analysointi- ja visualisointityökalu, joka mahdollistaa suurten tietomäärien hallinnan ja niiden muuttamisen ymmärrettäviksi raporteiksi ja visuaalisiksi esityksiksi. Sen intuitiivinen käyttöliittymä ja kyky integroitua monenlaisiin tietolähteisiin tekevät siitä erinomaisen valinnan erikokoisille organisaatioille, jotka haluavat tehdä tietopohjaisia päätöksiä. Power BI:n suosio kasvaa jatkuvasti, ja se on laajalti tunnustettu yhdeksi markkinoiden johtavista business intelligence -työkaluista. Business Intelligence (BI) -työkalut fasilitoivat liiketoiminta datan keruuta, prosessointia, analysointia ja visualisointia. Power BI on ollut markkinajohtaja BI-työkaluissa 16 peräkkäistä vuotta (2023 Gartner® Magic Quadrant™ I Microsoft Power BI).

Power BI:n tärkeimmät määrittävät ominaisuudet ovat datan integrointi, datan prosessointi, datan analysointi, datan mallinnus ja datan visualisointi. Datan integrointi viittaa tässä Power BI:n kykyyn ottaa yhteyttä lukuisiin erilaisiin datalähteisiin, kuten erilaisiin tietokantoihin, taulukkolaskentaohjelmiin ja liiketoiminta applikaatioihin. Power BI:ssä on tätä prosessia varten lukuisia valmiiksi rakennettuja datayhdistimiä.

Datan prosessointi viittaa tässä artikkelissa kaikkiin muutoksiin mitä lähdedataan tehdään, jotta sen pohjalta voidaan tehdä analytiikkaa. Power BI:n moottori tätä prosessia varten on Excelistä tuttu Power Query. Kaikki muutokset, mitä Power Queryssä tehdään, ilmaistaan Power BI:ssä M-kielen avulla.

Datan mallinnus on prosessi, jossa rakennetaan malli datan rakenteesta ja suhteista. Power BI toimii tehokkaimmillaan, kun data mallinnetaan tähtimalliin, jossa keskitetyt faktatiedot yhdistyvät suorilla suhteilla dimensiotietoihin. Power BI data-analytiikkakieli (DAX) on tehokkaimmillaan siloin, kun data on mallinnettu tällä tavalla.

Datan analysointi tapahtuu Power BI:ssä edellä mainitulla DAX-kielellä. Erilaiset analysoitavat liiketoimintalogiikat voidaan ilmaista DAX:in avulla koodimuodossa. Hyödyntämällä tehokasta visualisointia loppukäyttäjä saa nopeasti ja tehokkaasti kokonaisvaltaisen kuvan siitä, miten hänen liiketoimintansa kehittyy.

Datan visualisointi on prosessi, jossa muokattu ja liiketoimintalogiikalla rikastettu data esitetään intuitiivisesti niin, että loppukäyttäjä voi sisäistää monimutkaisia lukuja yhdellä silmäyksellä. Erilaiset visualisaatiot soveltuvat erilaisiin tarkoituksiin. Näyttäessä lukujen muutosta ajan yli viivadiagrammi on hyvä valinta. Vertaillessa kahden kustannuspaikan välisiä eroja pylväsdiagrammi osoittaa hyvin kategorioiden välisiä eroja. Tutkiessa kustannusten jakaumaa dimensioden yli piirasdiagrammi toimii moitteettomasti.

Miksi Power BI on paras vaihtoehto BI analytiikkaan?

Business Intelligenceä (lue data-analytiikkaa) voi kähtökohtaisesti lähestyä kolmesta eri kulmasta, jollet halua koodata omaa ratkaisuasi. Nämä vaihtoehdot ovat: Taulukko-ohjelma, valmiiksi rakennettu ohjelmisto tai BI-työkalu. Koitan nyt perustella, miksi sinun tulisi käyttää BI-työkalua näistä kolmesta vaihtoehdosta.

Oletetaan tilanne, jossa haluat tutkia miten liiketoiminnallasi menee. Mietitään, miten lähestyisit asiaa näillä kolmella eri työkalulla. Ensimmäinen vaihtoehtosi on ottaa esiin tuttu ja turvallinen Excel. Jotta voit analysoida lukuja mitä haluat tutkia, joudut joko kopioimaan luvut katsomalla ERP:iäsi ja kirjaamalla numerot manuaalisesti tai käyttämällä aikaisemmin mainittua Power Queryä. Toivottavasti et kopioi lukuja manuaalisesti, sillä inhimillisen virheen riski on suuri. Käyttämällä Power Queryä saat luvut kätevästi käyttöön ja analytiikkaa rakennettua. Seuraava haasteesi on lukujen jakaminen. Excel ei ole suunniteltu yhteiskäyttöön ja vaihtoehtonasi on lähettää tiedosto itsessään eteenpäin sähköpostilla tai siirtää Excel esimerkiksi OneDriveen. Molemmissa lähestymisissä on haasteena se, että henkilöt joille jaat tiedoston, voivat muokata sitä helposti. Tämä kuulostaa hyvältä, mutta sisältää riskejä. Olen kuullut lukuisia kertomuksia, joissa excel-tiedostoja ei uskalleta avata, koska pelätään, että “saatan rikkoa sen vahingossa niin en halua avata sitä”. Excel on siis helppokäyttöinen, mutta riskialtis muokattavuutensa takia. Tämän lisäksi sen ylläpitäminen sisältää paljon manuaalista työtä, ja kun haluat päivittää numeroita, joudut manuaalisesti hakemaan uudet datat.

Toinen vaihtoehtosi on käyttää valmiiksi rakennettua softaa, jonka jokin kooditalo on rakentanut. Ohjelmisto voi olla helppokäyttöinen ja se on vaikea ellei mahdoton rikkoa, mutta ongelmaksi muodostuu muokattavuus. Koska ohjelmisto ei todennäköisesti ole kehitetty juuri sinun firmallesi, vaan myytäväksi usealle organisaatiolle sen liiketoimintalogiikka ei todennäköisesti vastaa sinun liiketoimintaasi. Tapa jolla hinnoittelet tuotteesi saattaa poiketa kilpailijoistasi ja kustannuspaikkasi saattavat sisältää sellaisia dimensioita, mitä alkuperäisessä ratkaisussa ei otettu huomioon. Jotta saat kaiken irti ohjelmistosta, joudut ostamaan siihen kustomointia, mikä on usein erittäin kallista.

Kolmas vaihtoehtosi on käyttää BI-työkalua. Kuten Excelissä, pystyt käyttämään Microsoftin Powerqueryä datan muokkaamiseen. Voit rakentaa liiketoimintalogiikkasi DAX:in avulla juuri sinun liiketoimintasi mukaiseksi. Erona Exceliin on raportin jakaminen. Power BI-raportin voi julkaista Power BI serviceen, missä kaikki, kenelle haluat jakaa raportin, pääsevät katsomaan sitä tietoturvallisessa ja yksiselitteisessä sijainnissa. Jos et halua, että raporttia voi muokata, voit rajata muiden käyttäjien oikeuksia. Tällä tavoin raporttia ei saa rikki, ja kaikki voivat puhua liiketoiminnasta samoilla luvuilla. Power BI service tukee myös datan automaattipäivityksiä ja voit määrittää esimerkiksi, että raportti hakee uudet datat joka yö.

Miten voit ottaa Power BI:n käyttöön?

Power BI:n voi ottaa koekäyttöön ilman kustannuksia lataamalla Power BI desktopin. Jotta voit jakaa raportteja organisaatiossasi tarvitset lisenssin. Lisennssivaihtoehtoina on Power BI pro, Power BI premium käyttäjille tai Power BI premium/Fabric kapasiteetti. Pienille ja keskisuurille yrityksille kustannustehokkain vaihtoehto on usein Power BI pro lisenssien hankinta käyttäjille ketkä seuraavat raportteja. Nämä lisenssit maksavat noin 10 euroa per käyttäjä kuukaudessa.

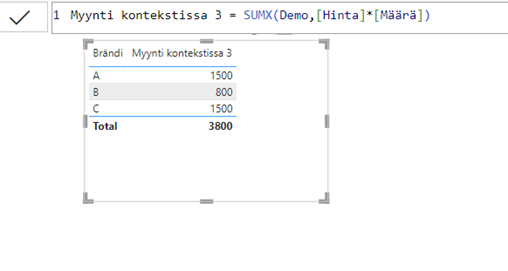

Raporttien kehittämisessä on muutamia sudenkuoppia, jotka liittyvät Power BI:n ja Excelin välisiin eroihin. Modernoidessa raportteja on hyvä olla tietoinen miten DAX:in “suodatinkonteksti” toimii laskentaa arvioidessa. Hieman teknisemmin sanottuna Excelin laskenta perustuu niin sanottuihin visuaalisiin kaavoihin, kun taas Power BI:n laskenta perustuu edellä mainittuun suodatinkontekstiin.

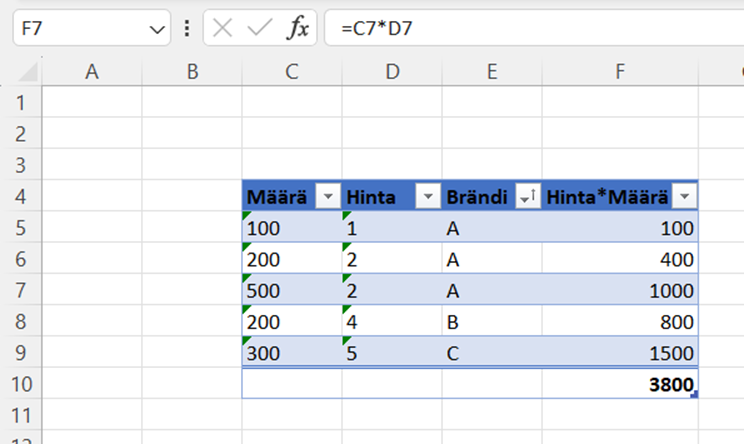

Esimerkki

Tavoitteena on laskea kokonaismyynti siten, että myyntimäärä kerrotaan myyntihinnalla.

| Määrä | Hinta | Brändi |

| 100 | 1 | A |

| 200 | 2 | A |

| 500 | 2 | A |

| 200 | 4 | B |

| 300 | 5 | C |

Excel:

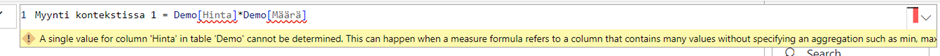

Koska DAX ei perustu visuaalisiin laskentoihin, yrittäessä samaa laskentaa Power BI:ssä, ohjelma antaa seuraavan virheen:

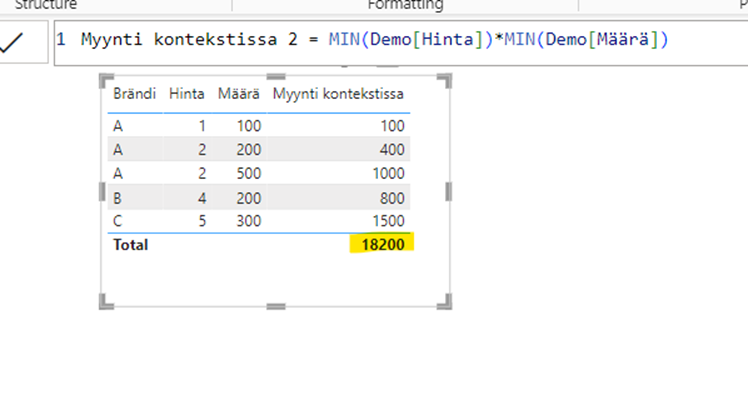

Käyttämällä ehotettua korjausta kaava alkaa näennäisesti toimimaan, mutta jostain syystä totaali näyttää omituiselta:

Tämä käyttäytyminen on esimerkki laskentalogiikan erosta. Excel laskee summan solujen F5:F9 välillä, mutta Power BI laskee totaalin “tyhjässä laskentakontekstissa”. Käytännössä tämä tarkoittaa sitä, että Power BI aggregoi luvut niin, että brändiä ei ole määritelty. (1+2+2+4+5) * (100+200+500+200+300) = (14)*(1300)=18200

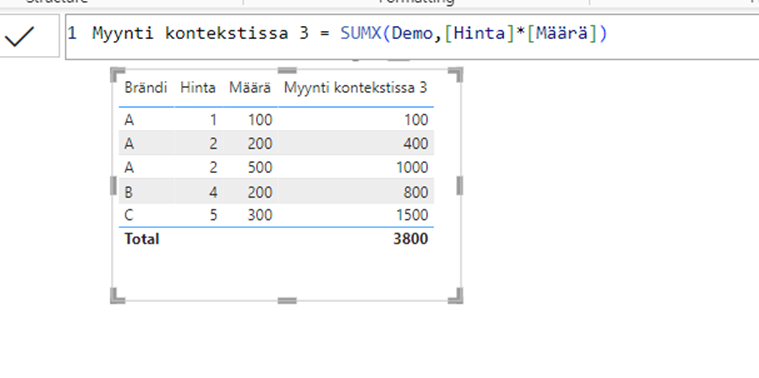

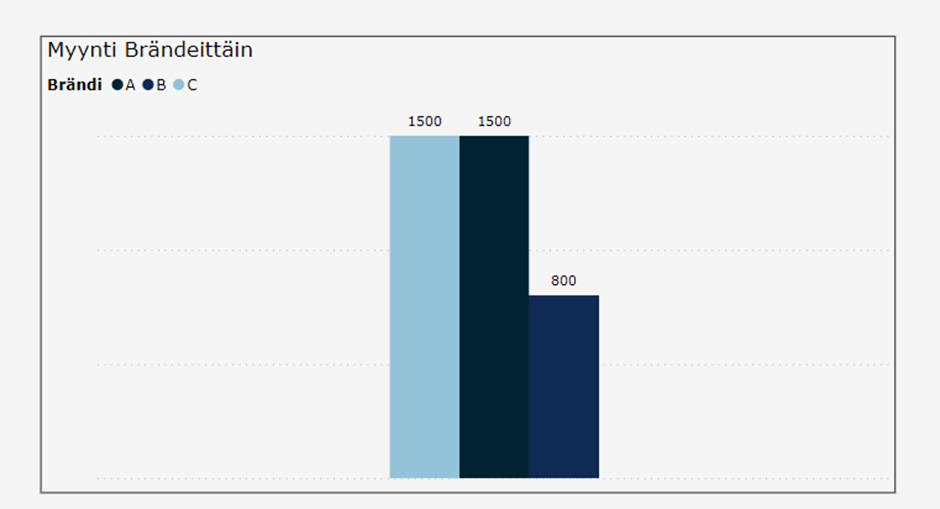

Huomioimalla laskentalogiikan ja käyttämällä eri kaavaa luvut täsmäävät:

Nyt, kun laskentalogiikka on huomioitu, voimme helposti muokata visuaalia ja pääsemme hyödyntämään Power BI:n ominaisuuksia. Voimme esimerkiksi poistaa turhat sarakkeet:

…ja muuttaa taulukon pylväsdiagrammiksi:

Yhteenveto

- Power BI on Microsoftin kehittämä BI-työkalu, joka tarjoaa käyttäjilleen tapoja toteuttaa kaikki tarvittavat data-analytiikan prosessit.

- Power BI:n avulla saat parhaat puolet helposti muokattavasta Excelistä ja robusteista SaaS-pohjaisista analytiikkaratkaisuista. Ohjelma on helposti muokattava ja mukautuu liiketoimintaasi, mutta sen käyttö on luotettavampaa ja läpinäkyvämpää, kuin helposti rikkoutuvat Excel-ratkaisut.

- Power BI:n lisenssit ovat halvimmillaan 10e/kk/käyttäjä

Kun ohjelmiston laskentalogiikan hallitsee, sen avulla voi rakentaa nopeasti näyttäviä ja informatiivisia visualisointeja.

DB Pro Services tarjoaa kattavia ratkaisuja ja asiantuntijapalveluita tiedolla johtamisen haasteisiin. Tarjontamme kattaa muun muassa datastrategian, modernien data-alustojen, sekä edistyneen analytiikan kokonaisuudet, kuin myös vaativat datamigraatiot. Ota yhteyttä, niin autamme sinua ja organisaatiotasi hyödyntämään tietoa tehokkaasti ja menestymään kilpailussa!

Valtteri Nättiaho

Lead Data Analyst

Valtteri.Nattiaho@dbproservices.fi

DB Pro Services Oy

Power BI:n käyttö monessa organisaatiossa on räjähtänyt käsiin ja sen hyödyt jäävät helposti saavuttamatta puutteellisilla ohjeistuksilla ja osaamisella. Syntyy helposti huonolaatuista ja virheellistä informaatiota sisältäviä raportteja, joka ohjaa liiketoimintapäätöksiä väärään suuntaan. Power BI Governance -mallin tarkoitus onkin luoda yrityksille toimintaedellytykset toteuttaa toimivaa ja luotettavaa tiedolla johtamista Power BI:n avulla!

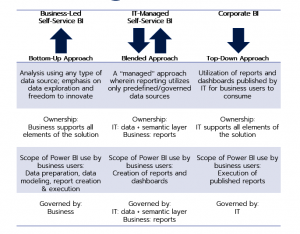

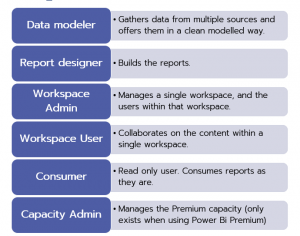

Power BI Governance -selvitys muodostuu kuudesta pääkohdasta. Niissä kussakin valitaan yritykselle sopivat toimintamallit ja luodaan selkeät priorisoidut stepit, miten governance -malli otetaan käyttöön. Framework sisältää seuraavat kokonaisuudet:

- Nykytila-analyysi

- Keskeisten roolien ja vastuiden selvittäminen

- Deployment-strategian valinta

- Systeemi Governance asiat

- Toteutusstrategiat

- Budjetti ja roadmap tuleville hankkeille

Suunnitelmaa kannattaa lähteä toteuttamaan heti budjetin ja roadmapin mukaisesti. Varsinkin siinä vaiheessa, kun tarkoituksena on käyttää Power BI:tä businesskriittisiin sovelluksiin prosessien ja toimintamallien on syytä olla 100-prosenttisessa kunnossa. Ohessa on muutamia tarkempia kuvia selvityksen eri vaiheista, mutta jos asia on ajankohtainen niin ota ihmeessä yhteyttä niin järjestetään Teams-palaveri ja käydään malli tarkemmin läpi!

Azure Purview ja Power BI -integraatio

Azuren uusi data governance -ratkaisu Purview (preview) on loistava lisä Power BI Governance selvitykseen ja tietovirtojen hallintaan. Azure Purview/Power BI -integraatio mahdollistaa datavirtojen tunnistamisen hybridiympäristöissä havainnollisilla visuaalisilla työkaluilla. Kun Purview on konfiguroitu käyttöön se osaa ylläpitää ja päivittää sisältöä automaattisesti. Sen avulla Power BI -ympäristön hallinta on entistä helpompaa. Ohessa on linkki Microsoftin julkistusvideoon Purviewestä viime vuoden lopulta. Jos kuitenkin haluatte nähdä tarkemman demon erityisesti Purviewn Power BI -integraatiosta niin ota yhteyttä ja järjestetään teille Teams-demo aiheesta!

Purview:n Power BI -integraation mahdollisuudet:

- End-to-End data lineage

- Data source impact analysis

- Define a business glossary

- Find trustworthy data

- Keep your data protected across your data estate

Lue myös: Master Data ja Master Datan hallinta osana BI arkkitehtuuria

Tehot irti BI-analytiikasta, Power BI vuonna 2024

Power BI-raportointi – tasapaino tekniikan ja muotoilun välillä

DB Pro Services ja Visma Solutions yhteistyöhön Severan Power BI -rajapinnan toteuttamisesta.

Microsoftin Power BI on moderni ja tehokas datan analysointi- ja raportointiratkaisu, jonka avulla yrityksen kriittistä liiketoimintatietoa voidaan jalostaa, analysoida ja julkaista halutuille käyttäjäryhmille. Power BI:n avulla data saadaan visualisoitua helposti ymmärrettävään muotoon, kuten esimerkiksi dashboardeiksi niin, että loppukäyttäjiltä ei vaadita mitään business intelligence -ratkaisuiden osaamista. Power BI soveltuu sekä nopeaan ad-hoc tyyppiseen itsepalveluraportointiin että toistuvien raporttien tuottamiseen esim. päivä-, viikko- tai kuukausitasolla. Tuotetut raportit tai dashboardit voidaan julkaista käyttäjien nähtäväksi Power BI -desktoppiin, mobiilisovellukseen tai siten ne voidaan upottaa intranettiin tai office 365 -tuotteisiin kuten SharePoint, Teams tai Dynamics.

Visma Severa on asiantuntijayrityksille suunnattu projektinhallinta-järjestelmä, joka tuo CRM:n, projektien aikataulutuksen, resursoinnin, työajanseurannan sekä laskutuksen yhteen työkaluun. Severa kerää hajanaiset tiedot yhteen paikkaan ja kaikki työntekijät ovat saman työkalun äärellä. Severan avulla teet liiketoiminnan ohjaamisesta visuaalista, vaivatonta ja läpinäkyvää.

Visma Solutions ja DB Pro Services ovat sopineet yhteistyöstä, jolla Severan tietosisältö on helposti tuotavissa yrityksen Power BI -ratkaisuun datan jalostamista ja julkaisemista varten. DB Pro Servicen toteuttaman rajapinnan avulla tarvittava integraatio on toteutettavissa nopeasti verrattuna siihen, että sitä lähdettäisiin toteuttamaan yrityskohtaisesti. Ja mikäli Power BI ei ole yrityksellenne tuttu väline, tarvittaessa DB Pro Serviceltä on hankittavissa asiantuntija-apua niin datan muokkaamisen ja jalostamiseen kuin raporttien/dashboardien suunnitteluun ja toteuttamiseen.

Jos haluat kaiken hyödyn irti Severan sisältämästä liiketoimintatiedosta, niin lue lisää Visman sivuilta: https://psa.visma.fi/integraatiot/db-pro-services-power-bi/ tai ota yhteyttä DB Pro Servicen myyntiin, jani.savolainen@dbproservices.fi

Inkrementaalilataus Power BI Pro:ssa!

Käytettäessä Power BI:tä on ollut tähän asti yksi iso ongelma: Jos faktojen datamäärät ovat suuria, kestää raporttien päivittäminen aina kauan, koska koko datamassa pitää aina ladata sovellukseen uudestaan. Uuden Power BI version mukana tuli uusi ominaisuus, eli muutoslataukset. Tämä nopeuttaa sekä kehitystyötä, että ajastettujen latausten läpimenoaikoja, kun pelkät muutokset otetaan mukaan. Tästä on myös se hyöty, ettei yhteyttä tietolähteisiin tarvita pitää auki niin pitkään enää. Ja mikä hienointa, tämä ominaisuus on käytössä myös Power BI Pro-lisenssillä!

Käyttöönotto vaihe 1 – Power Query

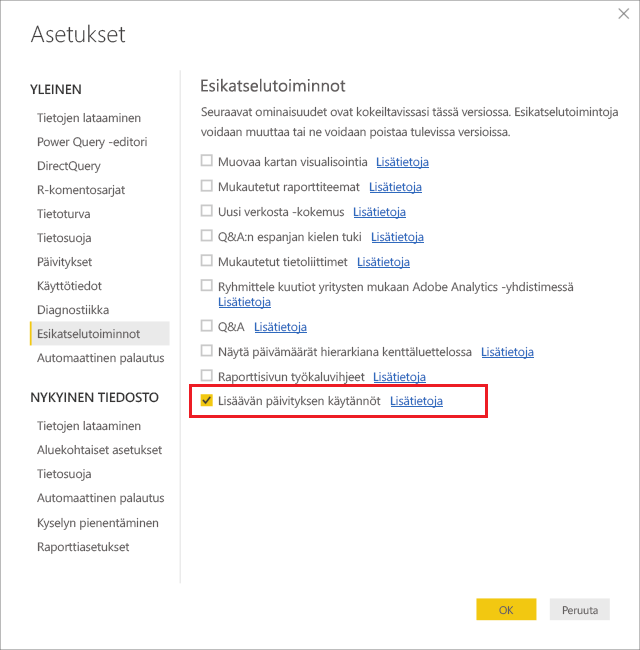

Lisäävä päivitys otetaan käyttöön Power BI Desktop työkalun asetuksista.

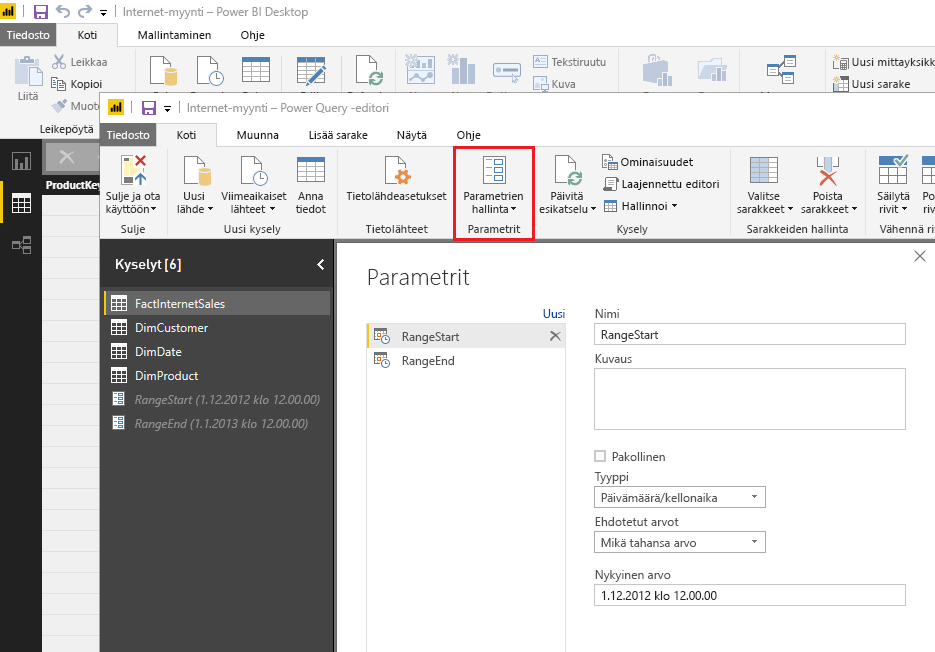

RangeStart– ja RangeEnd-parametrit luodaan Power Query editorista parametrien hallinta -kohdasta.

Nämä parametrien nimet ovat case-sensitiivisiä, koska ne ovat kiinteästi käytössä PBI algoritmiin koodattuna, ja PBI palvelussa niille ei enää tarvitse tehdä mitään. Eli ole tarkkana että kirjoitat parametrien nimet juuri oikeassa muodossa!

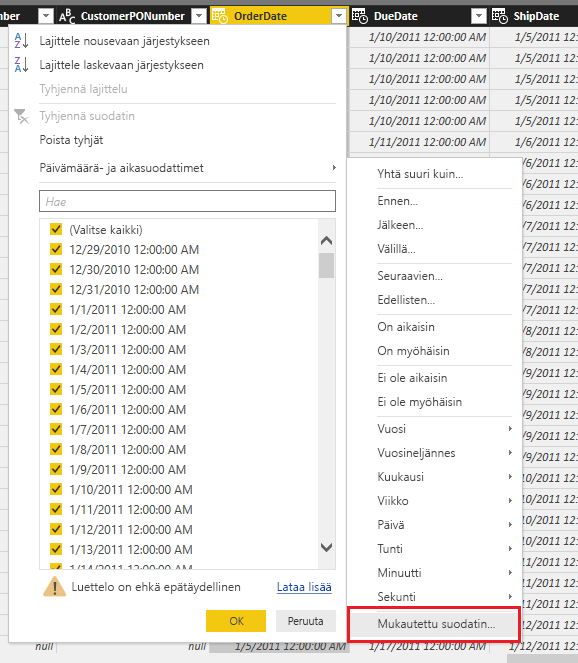

Kun parametrit on luotu voidaan ne ottaa käyttöön Power Query editorin päivämäärä sarakkeeseen määrittelemällä “mukautettu suodatin” kohdasta.

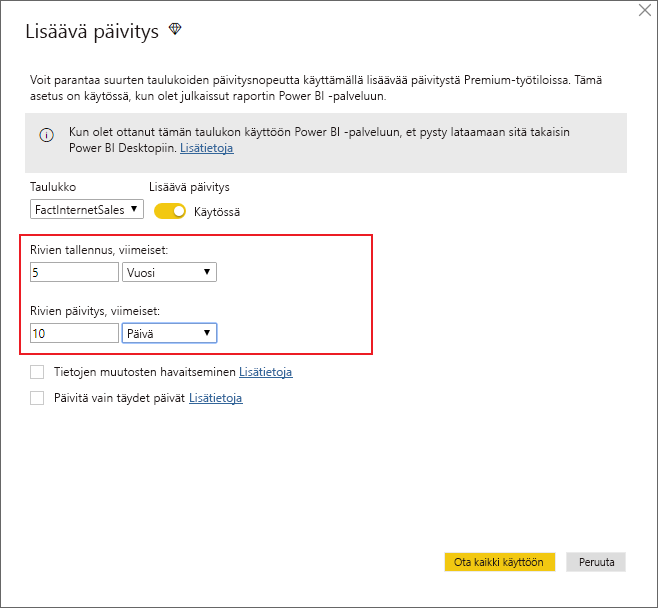

Käyttöönotto vaihe 2 – Datasetin asetukset ja julkaisu

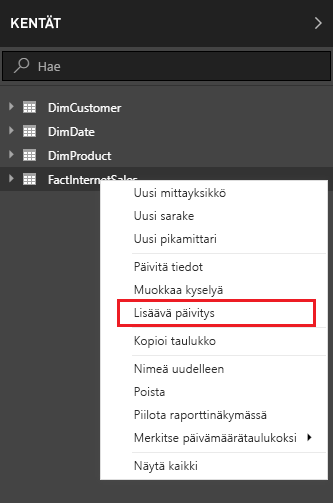

Power BI desktopin raporttityötilassa ja sen KENTÄT -ikkunassa “Lisäävä päivitys” -kohta löytyy taulun pikavalikosta.

Jos Power Query:ssa ei ole tehty parametrejä oikein, tämä valinta ei ole käytettävissä. Seuraavassa näkymässä määritellään mm. datasetin koko sekä kuinka pitkältä ajalta data päivitetään.

Ensimmäinen lataus kestää hieman kauemmin, koska lähdejärjestelmistä ladataan 5 vuoden historiatiedot ensimmäisen kerran. Tämä riittää Power BI Desktopin tiedoston asetuksista, seuraavaksi vain julkaisu verkon työtilaan ja “Lisäävä päivitys” on käytössä automaattisesti.

Rajoitukset

- Uuden ominaisuuden tuki perustuu lähdejärjestelmiin jotka osaavat käyttää SQL-syntaksia

- Muut lähteet, esimerkiksi BLOB, Excel, REST, CSV eivät toimi suoraan

- Inkrementaalilatauksen sisältävä PBIX tiedosto joka ladataan työtilasta kehityskoneelle ei ole enää muokattavissa. Tulevissa versiossa tämä pitäisi olla mahdollista.

Power BI Dataflows – enemmän aikaa tiedon analysointiin

Power BI on mitä mainioin itsepalvelu-BI-työkalu. Se sisältää monipuoliset tietolähdeyhteydet, ETL-työkalun, tehokkaan muistinvaraisen kuution sekä raportointityökalut samassa paketissa. Itse asiassa niin tiiviissä paketissa, että kertaalleen tehdyn ratkaisun uudelleenkäyttö järkevästi on ollut lähes mahdotonta.

Power BI -raportin kuution pystyy toki siirtämään Azure Analysis Services -kuutioksi pienen kikkailun jälkeen, mutta ETL-työkalulla eli Power Queryllä toteutettuja datasettejä ei ole voinut uudelleenkäyttää muuten kuin kopioimalla M-koodi raportista toiseen. Power BI Dataflows poistaa tämän tuskan! Sillä toteutettu Power Query -datasetti on helposti liitettävissä toisiin Power BI -raportteihin sekä myös muihin Azure Data Platform -tuotteisiin. Väitän, että tällä ratkaisulla pystytään säästämään melkoinen määrä aikaa ja rahaa yrityksissä, joissa Power BI on laajasti käytössä. Aikaa jää enemmän tiedon analysointiin, kun data on valmiiksi pureskeltu ja jaettu Dataflow:n kautta.

Kuinka Power BI DataFlows otetaan käyttöön?

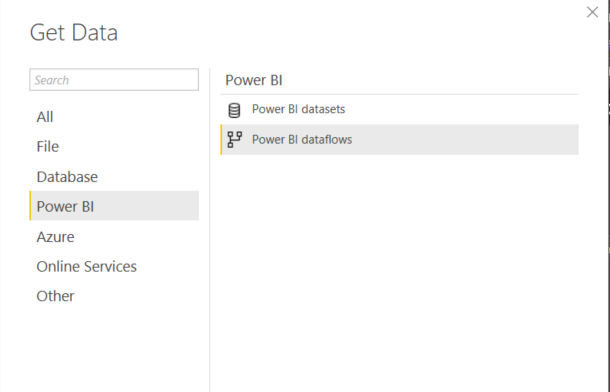

Teknisestä näkökulmasta Power BI Dataflows on irrallinen Power Query -prosessi, joka toimii Power BI -palvelussa. Yksi Dataflow voi koostua useammasta erillisestä tai linkitetystä tietojoukosta. Näitä tietojoukkoja voi ottaa helposti käyttöön Power BI -raportissa Power BI Dataflows -datalähteen kautta. Preview-vaiheessa ollut datalähde on nyt virallisesti saatavilla Power BI Desktopin April 2019 -julkaisussa (ks. kuva)

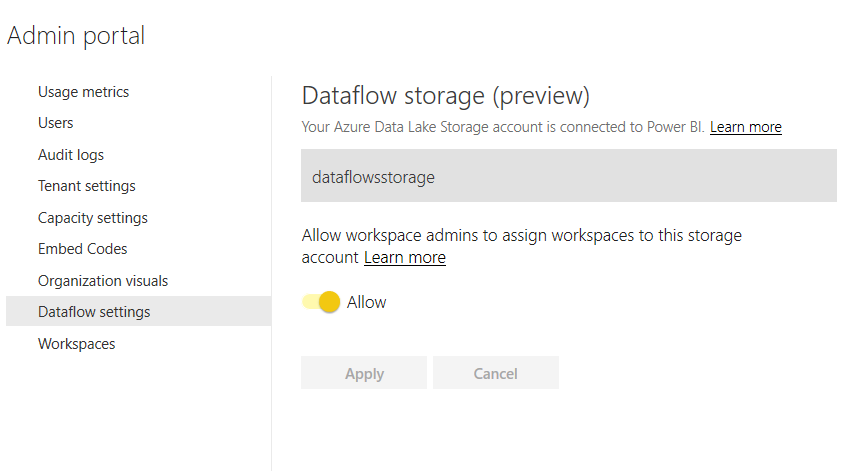

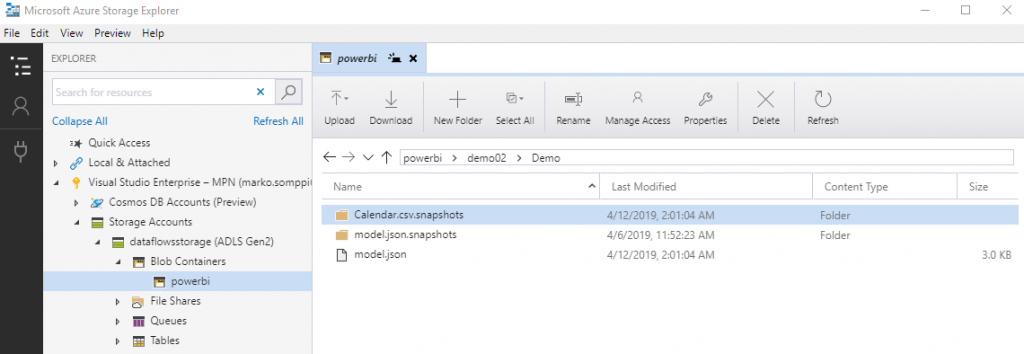

Oletusasetuksilla Dataflow tallentaa tiedot Power BI:n sisäiseen storageen ja siihen ei ole pääsyä muuten kuin Dataflow:n kautta. Tämä on kuitenkin mahdollista muuttaa niin että data tallennetaan organisaation Azure Data Lake Storage Gen2:een, mikä taas avaa ovet datan käyttämiseen myös muilla Azuren työkaluilla. Data Laken käyttö vaatii tietysti voimassaolevan Azure-tilauksen. Hyvät ohjeet ADLS Gen2:n liittämiseen löytyy täältä. Kun ADLS Gen2 on luotu, asetettu tarvittavat oikeudet Power BI Service, Power BI Premium ja Power Query -tunnuksille sekä Power BI admin -portaalin kautta liitetty Data Lake käyttäjän Power BI -tenanttiin, näyttää lopputulos tältä:

Power BI Dataflow ADLS Gen2:ssa

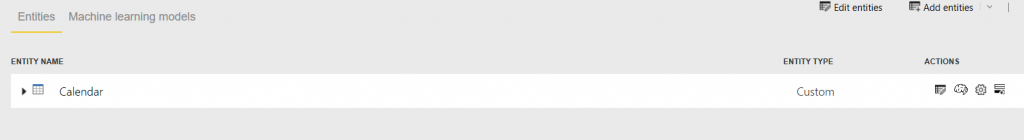

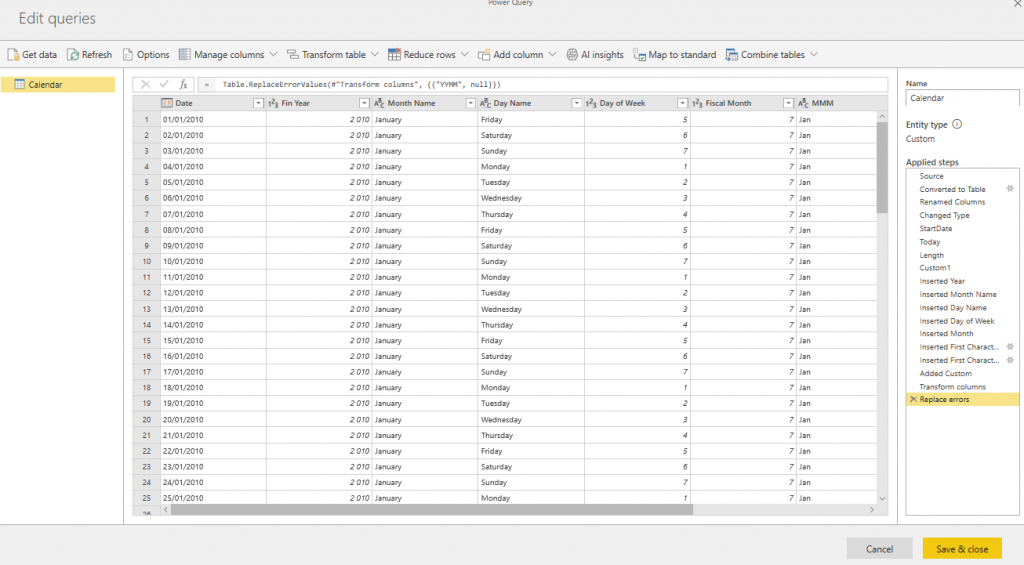

Miten data sitten tallentuu ADLS Gen2:een? Testasin tätä yksinkertaisella esimerkillä ja siirsin Power BI -raportista Calendar-taulun Dataflow-datasetiksi.

Power Query -editori on lähes samanlainen kuin Power BI Desktop -työkalussa. Helppo tapa siirtää koodi desktopista on käyttää Power Queryn advanced-editoria. Ohessa kuva Calendar-taulun editointinäkymästä siirron jälkeen.

Kun datasetti on valmis pitää se tietysti prosessoida ennen kuin data tallentuu Data Lakeen. Prosessointi on lähes identtinen verrattuna Power BI -datasetin vastaavaan. Prosessoinnin voi tehdä kertaluonteisesti tai sitten ajastaa.

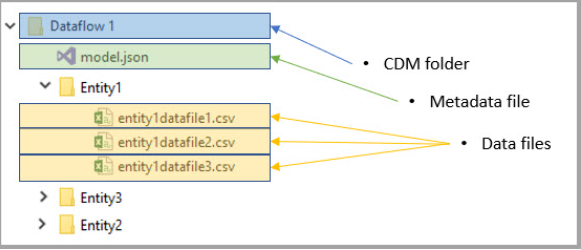

Microsoftin dokumentaation mukaan data tallentuu ADSL Gen2:een CDM (Common Data Model) -rakenteeseen. Model.json sisältää datan metatiedot ja kukin datasetti on omassa kansiossa csv-tiedostoina (ks. kuva alla).

Calendar-demossa datarakenne ja hakemistot näkyvät alla. Huomattava on että model.json:lla on oma hakemisto josta löytyy tiedoston versiohistoria (model.json.snapshots).

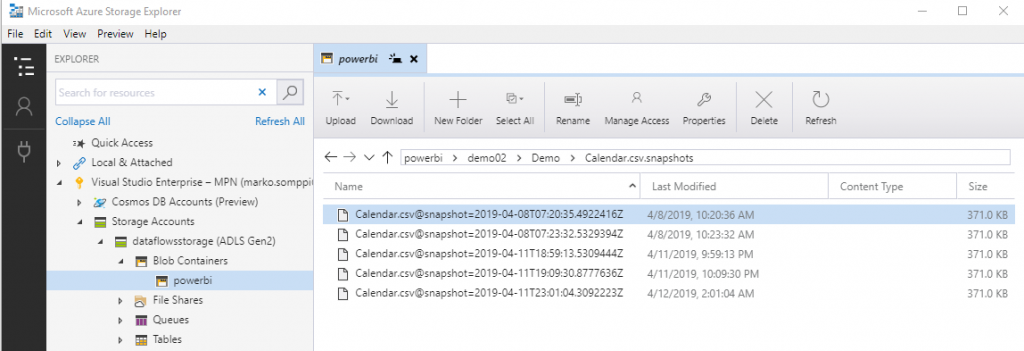

Calendar-data on tallennettu hakemistoon Calendar.csv.snapshots. Datasta tallentuu useita eri versioista. Eli jokainen datan päivitys luo uuden version, ja model.json-tiedostossa on partitions-kohdassa viittaus viimeisimpään versioon. Nykyisestä Dataflow:n versiosta tähän ei löydy mitään konfigurointivaihtoehtoja eikä Microsoftin dokumentaatiossa ole näistä vielä mitään mainintaa. Ehkä “snapshottien” määrää ja muita vastaavia voi säätää Dataflow:n tulevissa päivityksissä.

Power BI Dataflow -lisensointi

Power BI Dataflow tuntuu olevan jo kohtalaisen valmis kokonaisuus, ja suosittelen ehdottomasti sen testaamista. Huomattava on kuitenkin, että kaikki samat datalähteet mitä löytyy Power BI Desktopista eivät vielä ole tuettuna Dataflow:ssa. Lista tällä hetkellä tuetuista lähteistä löytyy täältä. Lisäksi Dataflow toimii Power BI Pro -lisenssillä, mutta jos käytössä on Power BI Premium, pääsee nauttimaan sen kaikista ominaisuuksista.

Oheisessa taulukossa on tällä hetkellä tiedossa olevat erot ominaisuuksissa lisenssin mukaan:

| Dataflow Capability | Pro | Premium |

| Connectivity | All connectors to all sources | All connectors to all sources |

| Storage | 10 GB per user | 100 TB for P1 or greater nodes |

| Data ingestion | Serial ingestion of entities, making data refresh longer | Parallel ingestion of entities |

| Incremental updates | Not available | Available |

| References to entities in the same workspace | Not available | Available, allowing the creation of complex data prep processes using multiple dataflows |

| References to entities across workspaces | Not available | Available, allowing full data consistency across the whole data estate |

| Calculation engine | Not available, since entities cannot refer to other entities, computed entities cannot be created | Available, allowing computed entities for complex data prep projects with multiple cleansing and enrichment steps |

| Refresh rates | Up to 8 times a day | Up to 48 times a day |

| Automated Machine Learning (preview) | Not available | Available |

| Cognitive Services (preview) | Not available | Available |

Milloin hyödyt Power BI Dataflow:n käytöstä?

Loppuun vielä ajatuksia siitä missä tilanteissa Dataflow:ta kannattaisi käyttää:

- Geneeristen

datasettien, kuten dimensioiden toteuttaminen. Esim. aikadimensiot,

organisaatiorakenteet, kustannuspaikat, tilihierarkiat, jne. - Excel-tiedostot,

jotka on tallennettu esim. Teamsiin tai Sharepoint-onlineen. Monesti näitä

tarvitsevat myös muut ja on paljon helpompaa ottaa datasetti käyttöön suoraan

Dataflow:sta. - Tilanteet,

joissa alkuperäiseen datasettiin ei ole mahdollista päästää useita käyttäjiä

tekemään raskaita kyselyitä samanaikaisesti. - Tilanteet,

joissa Power BI -raporttien toteuttajilla ei ole riittävää osaamista eivätkä he

tunne datalähteen liiketoimintalogiikkaa. - Silloin, kun

halutaan varmistaa, että mitään ylimääräistä ja tietoturvan kannalta

riskialtista dataa ei päädy raporteille ja analyyseihin. Näissä tilanteissa

tarjotaan valmiiksi käsitellyt datasetit Dataflow:n kautta raporteille.

Kaipaatko tukea Power BI:n käyttöönotossa tai hyödyntämisessä? Ota yhteyttä ja keskustellaan, kuinka voimme auttaa!

DB Pro Services

Lue myös Power BI raportoinnista